活体成像数据存储与传输的高并发解决方案设计

在活体成像技术迈向高帧率、多模态、长时程的今天,数据量的爆发式增长正成为科研效率的隐形瓶颈——一次高分辨率动态成像实验可能生成数TB的原始数据,而跨实验室协作或远程实时分析又对数据传输速度提出严苛要求。如何设计高并发、低延迟的存储与传输系统,让海量数据“存得下、传得快、用得好”,是解锁活体成像全潜力的关键技术命题。

数据洪流的挑战:从采集到分析的链式瓶颈

活体成像的数据洪流源于三大特性:

高帧率产生高频数据:1000帧/秒的高速成像每秒生成超过1GB的原始图像流,传统机械硬盘(HDD)的写入速度(约200MB/s)难以实时存储;、

多模态叠加数据维度:光学、CT、超声等多模态融合需同步处理异构数据格式,跨设备传输易引发协议冲突与延迟;

长时程积累数据总量:连续一周的肿瘤转移监测可能累积超过50TB数据,远超单机存储容量,且后期检索效率低下。

高并发存储:从边缘计算到分布式架构

边缘计算减轻核心负载

在成像设备端集成预处理模块,通过FPGA或ASIC芯片实时执行数据压缩、背景降噪等操作,将原始数据量压缩70%后再传输。科辰星飞EdgeFlow系统采用JPEG-XS无损压缩算法,在保证图像质量的同时,将单帧数据量从10MB降至3MB,支持16路相机并行采集。

分布式存储打破容量极限

基于Ceph或GlusterFS构建分布式存储集群,将数据分块存储于多节点,并通过冗余编码确保安全性。某肿瘤研究中心部署的50节点集群,总容量达10PB,支持每秒20GB的并发写入,可同时承载10台成像设备全天候运行。

分层存储优化资源分配

按数据热值(访问频率)自动分级存储:

热数据:SSD缓存近期采集的原始数据,供实时分析;

温数据:HDD阵列存储中期实验数据,支持快速检索;

冷数据:蓝光光盘库或磁带库归档长期数据,成本降低80%。

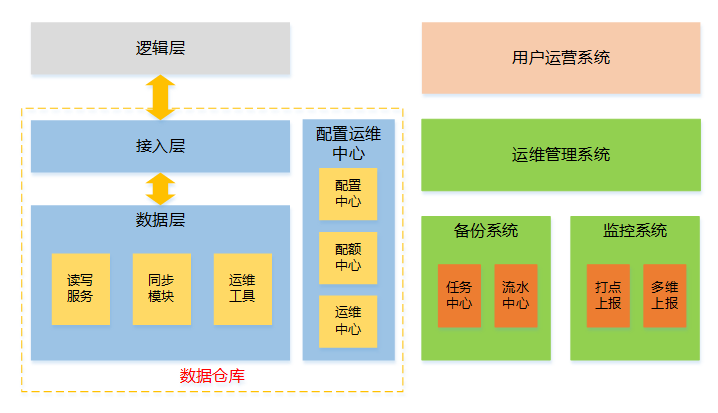

_20250527103225A966.jpg)

高速传输:从协议优化到智能路由

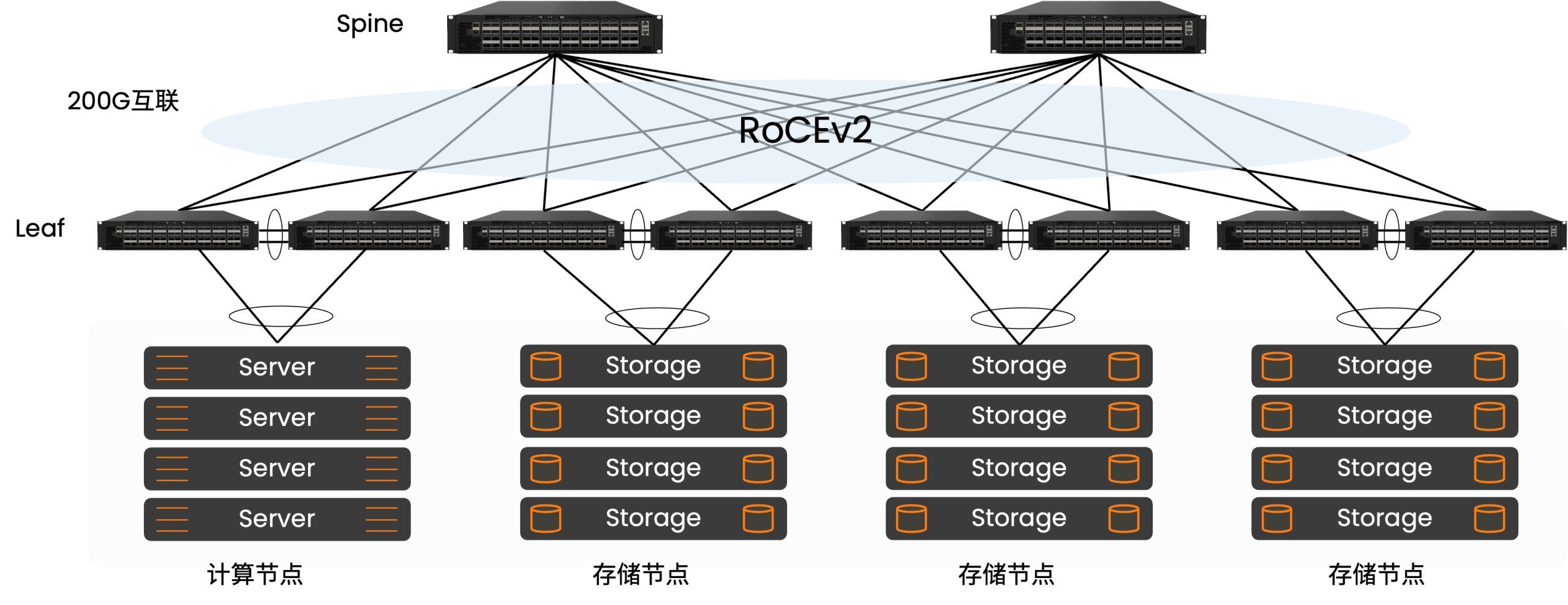

传统TCP协议因拥塞控制机制在高并发场景下效率低下。改用RDMA(远程直接内存访问)技术,绕过操作系统内核直接传输数据,延迟从毫秒级降至微秒级。复旦大学团队采用RoCEv2协议,实现跨校区100Gbps网络下4K影像流的实时无损传输,丢包率<0.001%;

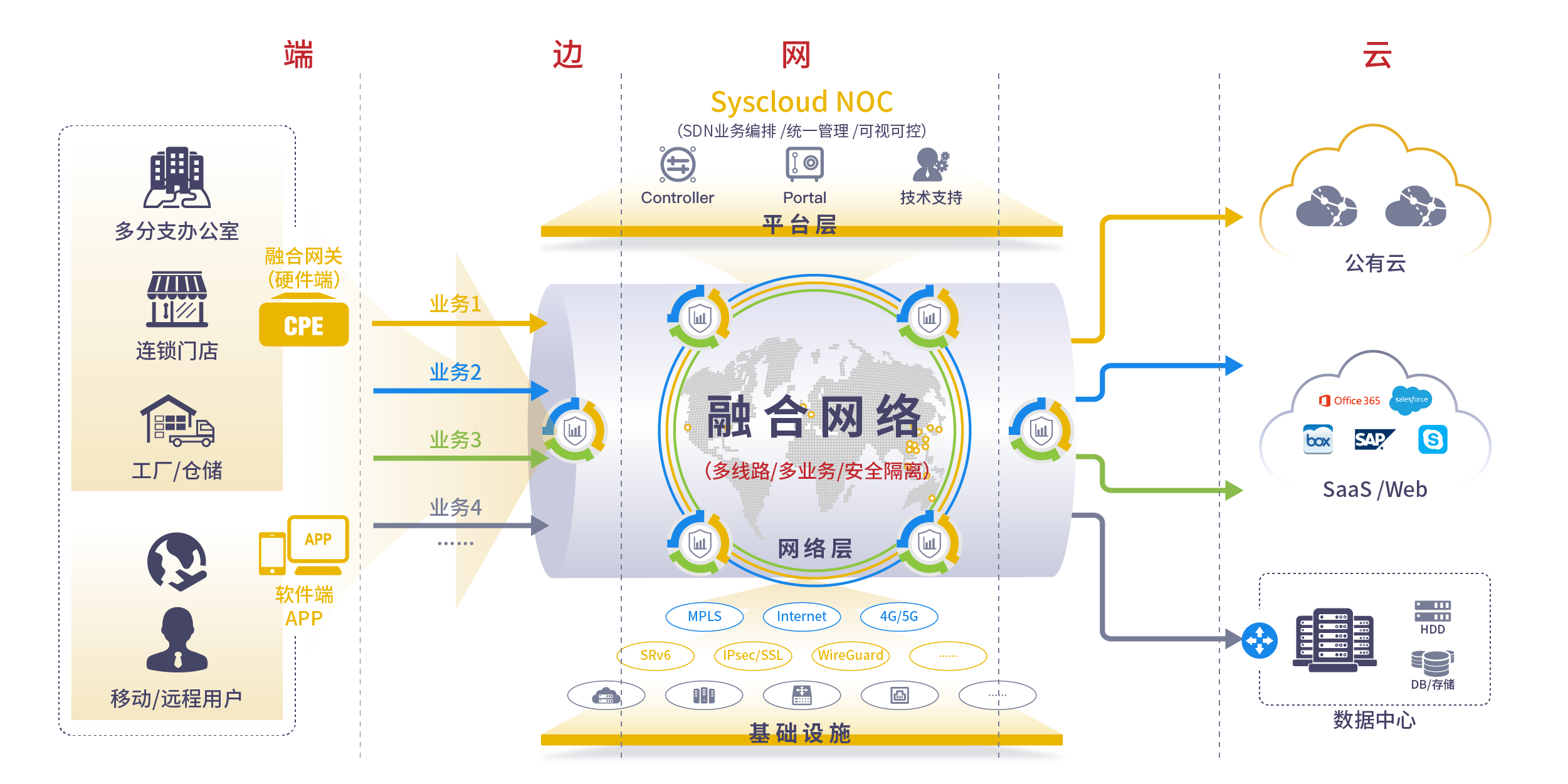

通过SDN(软件定义网络)动态规划传输路径,避开拥堵节点。科辰星飞DataMesh网络架构可依据实时带宽、延迟、数据优先级自动选择最优路径,在跨国多中心协作中将传输效率提升3倍;

将计算任务拆解至边缘设备与云端:

边缘端:执行实时预处理(如运动伪影校正);

云端:运行深度学习模型(如肿瘤分割算法);

传输链路:仅传输中间结果(如特征向量),数据量减少90%。

应用场景与价值验证

在阿尔茨海默病跨机构攻关中,分布式存储与智能路由技术使10家实验室共享PB级影像数据,联合训练出的AI诊断模型准确率达95%,较单中心模型提升20%。

神经外科术中活体成像需在30秒内完成数据采集、传输与三维重建。某医院部署的EdgeFlow系统通过5G专网+边缘计算,将“采集-诊断”延迟压缩至5秒,为肿瘤边界判定争取黄金时间。

针对自由活动动物的可穿戴成像设备(如微型超声贴片),通过LoRa无线网络将数据实时回传至边缘服务器,每日仅需传输100MB关键摘要,续航时间延长至72小时。

未来趋势:从基建升级到智能自治

AI预测性调度:通过历史数据学习实验规律,预分配存储与带宽资源,规避突发流量冲击;

区块链确权:为多中心数据共享提供可信溯源与权限管理,促进科研协作生态。