小动物活体成像多中心研究数据的标准化清洗与融合分析

在重大疾病研究领域,多中心联合攻关已成为提升科研效率与结论可靠性的核心策略。然而,当不同机构的小动物活体成像数据汇聚时,设备差异、操作规范不一、数据格式混乱等问题,往往导致“数据洪流”变为“数据沼泽”——看似资源丰富,却难以提炼出统一结论。如何通过标准化清洗与智能融合,将多源异构数据转化为高价值科研资产,是推动跨机构协作的关键技术命题。

数据异质性:多中心研究的“隐形壁垒”

设备差异:不同品牌成像系统的灵敏度、分辨率、光源波长存在差异,同一荧光信号可能被记录为不同强度;

操作偏差:麻醉深度、温控精度、探针注射剂量等实验细节的微小波动,会显著影响数据可比性;

格式碎片化:原始数据可能存储为TIFF、DICOM、HDF5等多种格式,且元数据标注不规范,增加整合难度。

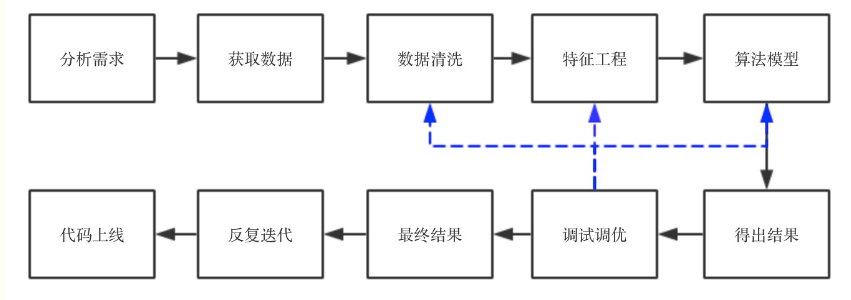

标准化清洗:从“原始数据”到“清洁资产”

元数据规范化

强制要求所有参与机构按统一模板标注元数据,涵盖设备型号、成像参数(如波长、功率、曝光时间)、动物信息(品系、体重、麻醉方案)等关键字段。科辰星飞MetaSync平台通过AI自动识别缺失字段并提示补全,错误率较人工录入降低80%;

信号强度归一化

基于仿体(Phantom)数据建立各设备的信号转换模型。例如,通过成像含已知浓度荧光微球的仿体,拟合每台设备的信号-浓度曲线,将原始数据转换为标准化单位(如光子数/cm²/秒)。某肿瘤药效评价项目中,归一化处理使不同中心数据的变异系数从35%压缩至8%;

异常数据清洗

构建基于机器学习的异常检测模型,识别并剔除问题数据:

技术异常:如运动伪影(模糊帧)、光源波动(亮度突变);

生物异常:如动物死亡前信号骤降、探针泄漏导致的非特异性荧光;

模型通过10万+标注数据训练,对常见异常的识别准确率达95%,较传统阈值法提升40%。

融合分析:从“简单叠加”到“深度挖掘”

多模态数据对齐

对于结合光学成像、CT、超声的多模态数据,采用仿体标定与特征点匹配算法实现空间-时间同步。例如,在脑肿瘤研究中,通过血管分支点作为标志物,将荧光信号与CT影像的配准误差控制在50μm以内;

异质数据联合建模

利用联邦学习框架,在不共享原始数据的前提下联合训练AI模型。某神经退行性疾病联盟采用该技术,整合8个中心的20万+影像数据,构建出全球首个帕金森病小鼠模型进展预测系统,准确率较单中心模型提升25%;

因果推断与偏倚校正

通过因果图模型识别混杂变量(如设备型号、操作人员经验),并采用逆概率加权法校正选择偏倚。在免疫治疗疗效分析中,该方法成功剥离了设备性能对结论的影响,使药物效应估计值更接近真实水平。

_20250530103605A991.jpg)

未来生态:自动化与可信化

AI驱动的全自动清洗:自然语言处理(NLP)自动解析实验日志,计算机视觉识别图像元数据,减少人工干预;

区块链赋能的信任机制:数据清洗与融合过程上链存证,确保可审计性与过程透明;

开源社区共建:建立统一的数据标准与工具库(如OpenImaging),降低中小实验室参与门槛。